显卡详情地址:

最近发生很多起拿博客文案去招摇撞骗的事件,后面发的所有文章都会标注发布时间(2028.8.26)

TG功能强大,做黑灰的TG也只能是首选,如果有其他平替,我是不愿意再用这个玩意的(并不是说所有的TG用户都如此,只是这个平台上的一些猴子演员可能比其他端更多,如果觉得被冒犯了,那可能说的就是你了)

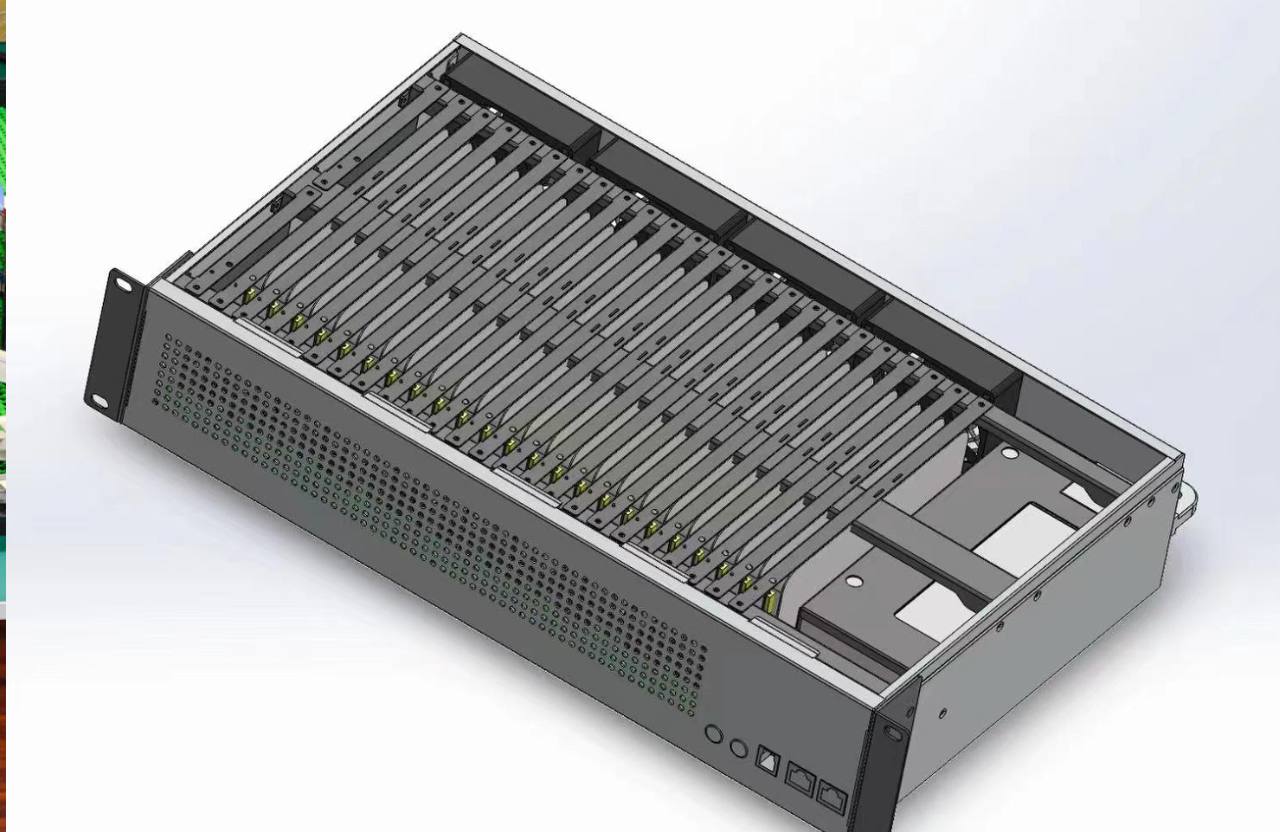

![图片[1]-小团队魔改显卡的经验和心路历程,方案已经小伙伴同意全部开源-老萬资源网](https://www.saiface.xyz/wp-content/uploads/2025/08/图片-40.png)

发现痛点

好了,进入正题,这个需求最早是在与徒弟的交流中发现的。上批徒弟大多数都是做批量产AI动作的工作室负责人。由于AI产出的那些玩意涉及到敏感隐私问题,很多团队百分之九十都选择本地部署。通常来说,按照AI工具的最低要求配置,比如一些小模型要求的3060 8G显卡,虽然能运行,但一天也就能产出20-30个素材,而且F8精度本身效果就很差,再加上这个效率,碰上一两个返工早饿死了。

所以很多人在结束后大都上了三万多的4090公版48G,但问题并没有完全解决。到了实际操作阶段,如果一条产线是三四个人,两台4090仍然远远不够支持全天候运行。由于只是给人产料,几乎是24小时两班倒不停歇地工作,显卡过热降效成了常见问题。每隔两三周就得停产一天更换一次硅脂来维护,不然显卡降频效率更低。

这些服务交付类的项目节奏都快,都是你不干有的是人干的状态,停产往往一天就损失了很多粘性客户,有人测试做过水冷方案,不过对这种消费级显卡来说,功耗和算力是成正比的,水冷的意义并不大,满功率同样压不住,所以我们就盯上了功耗和温度稳定的算力卡

V100的优势并不仅仅体现在价格上,作为上一代的算力卡皇,它最大的亮点在于对 NVLINK(多卡协同) 的支持。在现阶段的 40、50 系显卡或其他 5 代算力卡里都是不支持的

市面上不少转接卡是通过层层外包生产出来的,生产厂家往往觉得能点亮就算完成任务,完全没有把 掉驱动、主板兼容性差 等实际用户痛点纳入考虑。结果就是,真正需要 NVLINK 的人,还得额外花钱去买四张卡才能配上一块二手桥,既耗成本,又不实际,价位已经和4090对标了

很多熟悉老万的朋友可能还记得,这批显卡磨了一个多月都没上架。原因就是最早的思路陷在传统方案里:修补驱动、电容替换、脚本反推……反复绕圈。直到后来从转接桥方案里得到了启发:既然是爆改,那就不如直接 把 NVLINK 模组集成到底板里。这样一来,用户只需要安装好显卡,进系统,从官网下载驱动就能直接使用,跟不用移植什么颗粒这种增加人工成本的不实用方案。

测试初期

老万平时除了与工作室核账和答疑,其他时间都是泡在各大AI论坛和炼丹群里的,时间大约是上个月末,也就是七月份的二十多号,一个论坛里有人发布了V100 的改装方案,其实也很简单,就是一个服务器用的算力卡,接个转接板,没想到是噩梦的开始

由于每日双清的习惯,之前狼藉的折腾现场忘记拍照了,就用现在的成品来大概说一下

![图片[2]-小团队魔改显卡的经验和心路历程,方案已经小伙伴同意全部开源-老萬资源网](https://www.saiface.xyz/wp-content/uploads/2025/08/photo_2025-08-27_11-55-21-1024x626.jpg)

![图片[3]-小团队魔改显卡的经验和心路历程,方案已经小伙伴同意全部开源-老萬资源网](https://www.saiface.xyz/wp-content/uploads/2025/08/photo_2025-08-27_11-54-33-1024x590.jpg)

测试模型清单:

| Flux.1 | 文生图 | 良好,速度可接受,比3090 24G快将0.5倍,10次0曝显存 |

| LTX-Video | 图生视频 | sm_70 不支持 INT8,之后魔改的源码,手搓了三天,调试补差又用了一天 |

| Wan2.1/Hunyuan | 文生视频 | sageattention不支持,那天喝多脑抽入16G的来测试,签收才发现,又找店家补发的32G |

测试配置清单

| 配件 | 说明 |

| Tesla V100 SXM2 | 担心矿池卡,直接买的新的 |

| 魔改 PCIe 转接板 | PCB 也就那么回事 |

| 五热管服务器散热器 | 体积大,散热辣鸡 |

| 双风扇 + 风道卡具 | 散热辣鸡是跑起来才发现的,然后配置的一吸一吹 |

| PCIe 3.0 x16 延长线 | 测试板没用太好的,空间不够就弄了个延长线,纯丐 |

| 信越导热硅脂 | 高粘性强贴合,难摊,恶心 |

市面上确实存在一些脚本和二开固定驱动的解决方案,我们也都测试过反馈似乎并不理想,很多商家通过声称“只支持AMD平台”的方式来差异化营销,卖后却又把责任推给买家,说是“买家不会折腾”,驱动和架构不一的问题推卸到硬件身上,显然就是在坑不懂技术的小白,明显就是打着合规外衣的诈骗。

测试心路历程

算力卡本身是针对Ubuntu或Linux系统设计的,这也导致它在Windows系统上的兼容性较差。我们查阅了一些相关攻略,并确实遇到了以下几个问题:

- 驱动掉线:Windows系统对算力卡的驱动支持并不稳定,导致在使用过程中频繁出现掉驱动的现象。

- 空跑满负载:即便没有进行实际工作,算力卡也可能会无缘无故地跑满,

- 无故蓝屏和重启:没有明确原因的蓝屏和重启报错频繁发生

- 亮机卡不兼容主板:部分不兼容板子,甚至无法亮屏,对没有核显的人很不友好

排查一:

根据报错,高性能计算卡在最新的5XX.xx驱动程序下,重启后无法再次加载驱动,显卡无法正常使用。设备可以识别,设备状态显示的是“系统资源不足,无法启动API,代码:10”. 查了相关攻略:这个问题一般只针对5XX.XX版本的驱动程序才会出现,所以我们就可以安装4XX.XX的驱动程序,解决了空跑和蓝屏的问题

但问题就出现了:没法解决驱动突然掉线,使用V100都是给AI软件加速的,今年年更新的模型加速必须要求足够高版本的CUDA才可以调用加速卡加速。4XX.XX版本驱动对应的CUDA版本较低,可能无法满足较新版本要求。因此,在这种情况下,还是得用最新的5XX.XX版本的驱动,而且旧版本驱动无法全面适配最新五代的板子,虽然无故掉驱动问题解决了,但又出现了重启掉驱动,这些问题很头疼。毕竟我们钻研的目的是解决客户不想折腾,做到无脑适配,所以果断放弃

排查二

只要在每次关机或者重启电脑前,从设备管理器中手动卸载V100显卡,然后再关机、开机,或者重启,V100显卡就会自动识别到了。 注意:是卸载显卡,不是禁用显卡。

基于上述思路,只需要设置一个自动化运行的程序,但检测到你的电脑关机动作的时候(包括关机和重启),就自动运行卸载V100显卡的程序即可。

![图片[4]-小团队魔改显卡的经验和心路历程,方案已经小伙伴同意全部开源-老萬资源网](https://www.saiface.xyz/wp-content/uploads/2025/08/图片-41.png)

折腾结束,脚本是完全可以封装的,所以目前就暂时采取了这种方案,准备开始适配ComfyUI

驱动与系统配置:V100 想跑 ComfyUI 还要过几道坎

windows逻辑我们是很了解的,所以只需要了解Ubuntu的逻辑,后续才好进行反推,根据这个思路,我们开始了找虐之旅:当时的SSH还保留着记录,也放在了下面,小白可以选择性跳过

如果你有独立配置的能力,或者团队里养着技术且有想法降低成本折腾一番,可以参考下面代码,在外面直接购入原版卡,comfyui部署在Ubuntu上来运行

系统环境配置如下:

- 系统:Ubuntu 22.04.5 LTS(内核 6.8.0-40)

- Python:3.12(Conda 环境)

- 驱动:NVIDIA 575.64.03

- CUDA:12.4

- ComfyUI + 若干模型:Flux.1、Wan2.1、LTX-Video 等

BIOS 设置

- Above 4G Decoding → 开启

- CSM → 禁用

- UEFI 引导 → 必须

一个坑接一个坑

⚠️ 问题 1:依赖库缺失(libcusparseLt / libnccl / libcupti)错误提示:

ImportError: libcusparseLt.so.0: cannot open shared object file: No such file or directory

ImportError: libnccl.so.2: cannot open shared object file: No such file or directory

ImportError: undefined symbol: cuptiActivityEnableDriverApi, version libcupti.so.12原因:PyTorch 的 CUDA 后端依赖 cuSPARSELt(稀疏矩阵运算)、NCCL(多 GPU 通信)和 CUPTI(性能分析),但系统缺少这些库。解决: “缺啥装啥,反正 apt 装上就对了”。

安装 cuSPARSELt:

wget

https://developer.download.nvidia.com/compute/cusparselt/0.7.1/local_installers/cusparselt-local-repo-ubuntu2204-0.7.1_1.0-1_amd64.deb

sudo dpkg -i cusparselt-local-repo-ubuntu2204-0.7.1_1.0-1_amd64.deb

sudo cp /var/cusparselt-local-repo-ubuntu2204-0.7.1/cusparselt-*-keyring.gpg /usr/share/keyrings/

sudo apt-get update

sudo apt-get -y install libcusparselt0 libcusparselt-dev安装 NCCL:

wgethttps://developer.download.nvidia.com/compute/cuda/repos/ubuntu2204/x86_64/cuda-keyring_1.1-1_all.debsudo dpkg -i cuda-keyring_1.1-1_all.debsudo apt updatesudo apt install libnccl2 libnccl-dev

安装 CUPTI:

python -m pip install cupti-python验证

python -c "import torch; print(torch.cuda.is_available(), torch.cuda.get_device_name(0))"问题 2:LTX-Video-Q8-Kernels 不支持 sm_70 架构错误提示:

NotImplementedError: Not supported gpu!

原因:LTX-Video-Q8-Kernels 的 setup.py 未适配 Tesla V100 的 sm_70 架构,仅支持 Ampere(sm_80+)等较新架构。解决: 修改 setup.py,添加 sm_70 支持:

cd /tmpgit clonehttps://github.com/Lightricks/LTX-Video-Q8-Kernels.gitcd LTX-Video-Q8-Kernels

编辑 setup.py:

def get_device_arch(): major, minor = torch.cuda.get_device_capability(0) if major == 7 and (minor >= 0 and minor < 9): return "sm_70" if major == 8 and (minor >= 0 and minor < 9): return "ampere" if major == 8 and minor == 9: return "ada" raise NotImplementedError("Not supported gpu!")安装:

CUDA_VISIBLE_DEVICES=0 python -m pip install --no-build-isolation .验证:

python -c "import LTX_Video_Q8_Kernels; print('LTX-Video-Q8-Kernels installed')"问题 3:sageattention,FlashAttention 和 Triton 不支持 sm_70 架构

V100 是 Volta 架构(sm_70),而现在一堆 AI 框架都要求 Ampere 起步(sm_75 以上)。导致这些模块直接报错:

NotImplementedError: Not supported GPU!

解决:

- FlashAttention → 降级到 v1.0.9 + 修改代码适配;

- Triton → 降级到 3.0.0;

- PyTorch → 降级到 2.4.1 或 2.6.0(看情况);

- 安装 xformers + FP16 精度模式。

问题 4:Triton 编译失败(PassManager::run failed)错误提示:

File "/media/Work1/home/harrison/miniconda3/envs/comfyui/lib/python3.12/site-packages/triton/backends/nvidia/compiler.py", line 297, in make_ttgir

pm.run(mod)

RuntimeError: PassManager::run failed

原因:Triton 3.3.0 与 sm_70 兼容性差,sageattention 的 INT8 优化可能不支持 V100。PyTorch 2.7.1+ 要求 sm_75,而 PyTorch 2.4.1 是最后一个支持 sm_70 的版本。 解决: 回退到 PyTorch 2.4.1 和 Triton 3.0.0:

python -m pip uninstall torch torchvision torchaudio triton xformerspython -m pip install torch==2.4.1 torchvision==0.19.1 torchaudio==2.4.1 --index-urlhttps://download.pytorch.org/whl/cu124python -m pip install triton==3.0.0 --index-urlhttps://download.pytorch.org/whl/cu124python -m pip install xformers==0.0.28.post1 --index-urlhttps://download.pytorch.org/whl/cu124

验证:

python -c "import triton; print(triton.__version__)"输出:3.0.0

解决了这些问题,我们进行了一系列的反推,发现驱动还是需要客户来折腾,毕竟远程很费时间,只能一对一,大家都有自己的项目,当然也就没必要因小失大。

最后就在转接板上做文章:在转接板内焊接做好的集成模块,就完美解决了掉驱动的核心痛点,也就不需要什么脚本了,

显卡是焊到转接板,显卡坞则直接对显卡坞主板bios做了二次编译

后面则是找人开模,适配,拿着图纸批量化产出、最后即插即用的成果了,重复的内容不在做叙述,参考商品详情:

我们水冷版魔改方案结构图

![图片[5]-小团队魔改显卡的经验和心路历程,方案已经小伙伴同意全部开源-老萬资源网](https://www.saiface.xyz/wp-content/uploads/2025/08/photo_2025-08-27_11-56-28-1024x833.jpg)

V100 毕竟用途和功耗在那摆着,就是全天运行温度也不会高到哪去,这种方案纯粹是为了迎合大型团队的静音和图省事的需求。

禁止违规使用或商用,下载本站资源即视为同意本站所有协议,请下载后一小时内删除